El archivo robots.txt es un archivo de texto que le dice a los robots de búsqueda, como Google, qué partes de tu sitio web pueden ver y cuáles no. Si tienes un sitio en WordPress, saber cómo usar este archivo puede ayudar a que tu sitio sea más fácil de encontrar en internet. Este archivo pequeño puede hacer una gran diferencia en cómo los motores de búsqueda miran tu sitio. En este post, te explicamos qué es el archivo robots.txt, cómo cambiarlo, cómo mejorarlo y algunos consejos para usarlo bien.

El archivo robots.txt ayuda a poner reglas sobre cómo los robots, que también se llaman rastreadores, deben comportarse cuando visitan tu sitio. Es importante para decir qué partes de tu sitio deben ser vistas por los motores de búsqueda como Google o Bing y qué partes no. Si tienes un plan claro sobre qué debe ser rastreado y qué no, puedes hacer que tu sitio funcione mejor en los motores de búsqueda y ahorrar recursos.

- Qué es el archivo robots.txt y por qué es importante

- Cómo crear y editar un archivo robots.txt en WordPress

- Ejemplo de configuración básica del archivo robots.txt

- Ejemplo de configuración avanzada del archivo robots.txt

- Optimizar el archivo robots.txt

- Relación entre el archivo robots.txt y el SEO

- Conclusión

Qué es el archivo robots.txt y por qué es importante

El archivo robots.txt es un archivo de texto que se encuentra en la raíz de tu sitio web. Su objetivo principal es indicar a los bots de los motores de búsqueda qué partes de tu web pueden rastrear y cuáles deben evitar. Este archivo es uno de los primeros que un bot busca cuando llega a tu sitio, ya que quiere saber qué páginas o secciones tiene permitido analizar y cuáles debería dejar de lado.

Aunque no es obligatorio tenerlo, este archivo es útil para:

- Controlar el rastreo:

Evitar que los bots gasten tiempo en páginas irrelevantes. Esto te permite asegurarte de que las áreas importantes de tu sitio, como las páginas de productos o los artículos del blog, reciban más atención. Ten en cuenta que Google tiene un «presupuesto de rastreo» para cada web, es decir, que no rastrea todas la URLs que tenga, así que hay que priorizar las URLs que más nos interesen y sean la que aparezcan en Google. - Mejorar el SEO:

Ayudar a que Google y otros motores de búsqueda enfoquen sus esfuerzos en las páginas importantes. Cuando los bots se centran en rastrear páginas clave, el resultado es un mejor rendimiento en los resultados de búsqueda y una optimización del presupuesto de rastreo. - Ahorrar recursos del servidor:

Reducir el acceso de bots innecesarios que consumen recursos. Los rastreadores pueden consumir una cantidad significativa de ancho de banda y recursos de servidor y al limitar qué pueden acceder, se mejora la eficiencia del sitio.

Tener un archivo robots.txt también ayuda a evitar problemas de contenido duplicado, ya que puedes evitar que ciertas páginas sean rastreadas e indexadas en los motores de búsqueda. Esto puede ser especialmente útil en tiendas online con filtros de productos, donde podrían generarse muchas URL similares que compiten entre sí.

Ubicación del archivo robots.txt en WordPress

Por defecto, WordPress genera un archivo robots.txt virtual que puedes ver accediendo a:https://tusitio.tld/robots.txt

Este archivo suele ser muy simple y puede que no cubra todas las necesidades específicas de tu sitio web. Por ejemplo, podría no bloquear ciertas partes que deseas proteger o no incluir la ruta al sitemap.

En estos casos, puedes crear uno manualmente para tener más control sobre cómo los rastreadores interactúan con tu sitio. Crear un archivo personalizado permite adaptar las directivas a los cambios y las nuevas estrategias SEO que vayas implementando.

Cómo crear y editar un archivo robots.txt en WordPress

Crear el archivo robots.txt

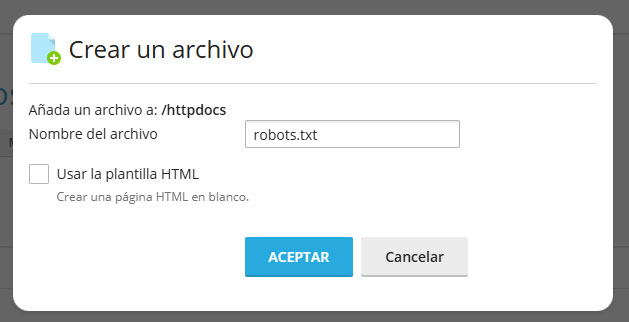

Si necesitas un archivo robots.txt personalizado, puedes crearlo desde cero siguiendo estos pasos:

- Abre un editor de texto como Notepad o cualquier herramienta similar.

- Guarda el archivo con el nombre robots.txt.

- Sube el archivo a la carpeta raíz de tu sitio web utilizando un cliente FTP como FileZilla o a través del gestor de archivos de tu hosting.

Este proceso te permite tener un archivo completamente a medida y asegurarte de que contiene exactamente lo que necesitas para mejorar la gestión del rastreo de los motores de búsqueda.

Si bien la tarea de crear un archivo robots.txt puede parecer simple, la configuración incorrecta de alguna directiva podría afectar el rendimiento de tu sitio en las búsquedas.

Editar el archivo robots.txt desde WordPress

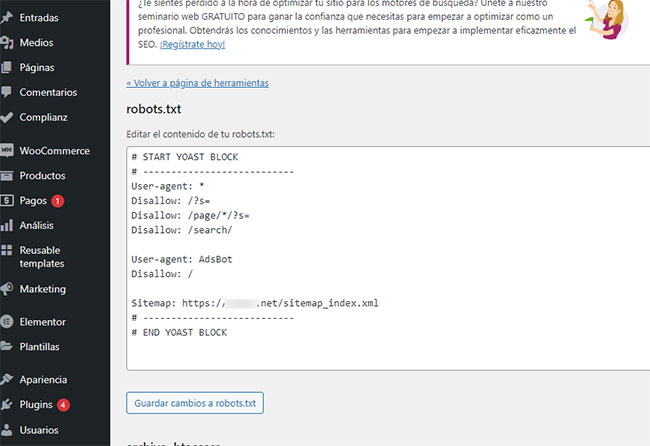

Algunos plugins facilitan la edición del archivo robots.txt directamente desde el panel de administración de WordPress. Uno de los más populares es Yoast SEO, aunque hay mucho otros que también lo hacen. Sigue estos pasos para editarlo:

- Instala y activa el plugin Yoast SEO.

- Ve al menú SEO > Herramientas > Editor de archivos.

- Allí encontrarás la opción para modificar tu archivo robots.txt directamente.

Yoast SEO no solo facilita la edición de este archivo, sino que también proporciona sugerencias sobre qué incluir o evitar en tu archivo robots.txt para mejorar el SEO. Si no quieres instalar un plugin adicional, también podrías considerar plugins como All in One SEO o directamente usar un gestor de archivos desde el panel de tu proveedor de hosting.

Ejemplo de configuración básica del archivo robots.txt

El archivo robots.txt debe incluir las instrucciones adecuadas según las necesidades de tu web. Aquí tienes un ejemplo básico para un sitio WordPress:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://tusitio.com/sitemap_index.xmlEste archivo indica que los bots no pueden acceder a la carpeta /wp-admin/, con una excepción para admin-ajax.php. Esto es necesario porque el archivo admin-ajax.php se utiliza para funcionalidades dinámicas, y bloquearlo podría causar problemas con la funcionalidad de tu sitio web. También se incluye la ruta al sitemap, lo cual es muy útil para mejorar la indexación de tu sitio.

Ejemplo de configuración avanzada del archivo robots.txt

Si deseas un archivo robots.txt más complejo, puedes incluir reglas para bloquear ciertos rastreadores específicos que no quieres que accedan a tu sitio. Esto puede ser útil si algunos bots consumen demasiados recursos o no aportan valor. Aquí tienes un ejemplo más avanzado:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://tusitio.com/sitemap_index.xml

# Bloquear rastreadores específicos

User-agent: BadBot

Disallow: /

User-agent: SpamBot

Disallow: /

# Permitir rastreadores útiles

User-agent: Googlebot

Disallow:

User-agent: Bingbot

Disallow:

# Limitar el acceso a ciertas carpetas

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /junk/En este ejemplo, estamos bloqueando bots específicos como BadBot y SpamBot, que podrían ser rastreadores que consumen recursos sin aportar beneficios. También estamos dando acceso completo a bots útiles como Googlebot y Bingbot. Además, limitamos el acceso a carpetas que no queremos que sean rastreadas, como /cgi-bin/, /tmp/ y /junk/.

Este archivo indica que los bots no pueden acceder a la carpeta /wp-admin/, con una excepción para admin-ajax.php. Esto es necesario porque el archivo admin-ajax.php se utiliza para funcionalidades dinámicas, y bloquearlo podría causar problemas con la funcionalidad de tu sitio web. También se incluye la ruta al sitemap, lo cual es muy útil para mejorar la indexación de tu sitio.

Es sólo un ejemplo para que veas cómo funciona, pero tú tienes que usar la configuración que más te interese para tu sitio web.

Qué significan estas líneas

- User-agent: Especifica los bots a los que se aplican las reglas (el asterisco se aplica a todos los bots). Si quisieras establecer reglas para un bot específico, como Googlebot, podrías hacerlo aquí.

- Disallow: Bloquea partes específicas de tu sitio, como el acceso al panel de administración, lo que ayuda a evitar que los rastreadores pierdan tiempo en áreas no relevantes para la indexación.

- Allow: Hace excepciones, permitiendo acceso a rutas específicas, como el archivo admin-ajax.php, que es necesario para las funcionalidades dinámicas.

- Sitemap: Indica la ubicación de tu archivo sitemap para facilitar el rastreo. Incluir el sitemap ayuda a los motores de búsqueda a conocer todas las URL importantes del sitio, mejorando así su eficiencia de rastreo.

Optimizar el archivo robots.txt

1. No bloquear contenido importante

Evita restringir el acceso a páginas o recursos que los motores de búsqueda necesitan para comprender tu sitio, como archivos CSS o JS. Estos archivos permiten a Google renderizar tu sitio adecuadamente, y bloquearlos podría afectar cómo tu página se muestra en los resultados de búsqueda.

2. Añadir el sitemap

Incluir la URL de tu sitemap es crucial para que los motores de búsqueda puedan rastrear todo tu contenido de manera eficiente. Un sitemap bien elaborado ofrece una guía clara sobre la estructura de tu sitio y ayuda a los bots a priorizar el contenido que debe ser indexado.

3. Evitar el exceso de restricciones

Un archivo robots.txt demasiado restrictivo puede impedir el rastreo de páginas clave y afectar negativamente tu posicionamiento en buscadores. A veces, al intentar ser muy protectores con el contenido, terminamos bloqueando recursos que ayudan a los motores de búsqueda a comprender mejor nuestra página.

4. Probar tu archivo robots.txt

Utiliza herramientas como el Probador de robots.txt de Google Search Console para verificar que tu configuración funciona correctamente. Esta herramienta te permite ver si tus reglas están bloqueando de forma adecuada y si los bots pueden acceder al contenido que consideras importante para el SEO.

Relación entre el archivo robots.txt y el SEO

Un archivo robots.txt mal configurado puede perjudicar tu estrategia de SEO. Por ejemplo, bloquear el acceso al sitemap o a recursos esenciales podría hacer que Google no indexe adecuadamente tu sitio. Esto puede llevar a una pérdida de visibilidad en los resultados de búsqueda y afectar negativamente tu rendimiento orgánico.

También es importante entender que el archivo robots.txt no es una solución para evitar que el contenido sea visible en Google. Para eso, deberías utilizar etiquetas noindex y otros mecanismos más avanzados. El archivo robots.txt solo impide que se rastree la página, pero no impide que se muestre si ya ha sido indexada.

Si tu objetivo es mejorar el rendimiento SEO de tu sitio, también es importante contar con un hosting WordPress optimizado que garantice rapidez y estabilidad. En Loading podemos ayudarte con esto, ya que disponemos de distintos planes, para que se puedan adaptar al tamaño de tu proyecto web.

Conclusión

El archivo robots.txt para WordPress es una herramienta muy útil para ayudar a controlar qué partes de tu sitio pueden ver los motores de búsqueda, como Google. Con una buena configuración, puedes asegurarte de que los motores de búsqueda se enfoquen en las páginas más importantes y eviten las partes que no son tan relevantes. Pero es importante tener cuidado al configurarlo, porque si haces un error, podría evitar que las páginas importantes sean vistas.

Si quieres aprender más sobre cómo bloquear el archivo robots.txt, mira nuestra guía completa aquí. Seguir buenas prácticas y probar el archivo regularmente te ayudará a mantener tu sitio funcionando bien y a tener éxito en los motores de búsqueda.